元宇宙与大数据,支撑大数据的基础——硬件架构(上篇)

元宇宙与大数据,支撑大数据的基础——硬件架构(中篇)

前篇提到,对于超级大型数据中心技术发展势在必行,但是当前大量已经在运行的数据中心,规模和架构还不完善。目前互联网巨头、ICP(电信与信息服务业务经营)和企业使用DCI(Data Center Interconnect)解决方案为其数据中心提供高质量且趋近无限带宽的连接,同时通过自建基础设施来控制成本。随着数据中心建设规模的海量增长,数据中心互联需求倍增,如何实现充分利用好有限的光纤资源、获得可靠的大容量传输是数据中心互联的挑战之一。

因光模拟信号的业务发放及维护模式不同于普通的数字网络,因此随着数据量的不断增大带来的设备量激增,快速开通业务、快速精准排障成为数据中心互联的新挑战。

因此,在构建DCI解决方案时,不仅需要考虑连接带宽的需求,还需要考虑运维简化、智能和安全等方面的需求。比如类似于DDC-distributed disaggregated chassis,将大机框分解,采用盒式交换机搭建大转发能力 DCI 角色设备。当前的很多ICP已经在开始布局相关产业,比如2019 年 AT&T 提交 DDC 白盒架构设计到 OCP, 2020 年 AT&T 在 IP 骨干网部署 Drive nets DDC 设备。

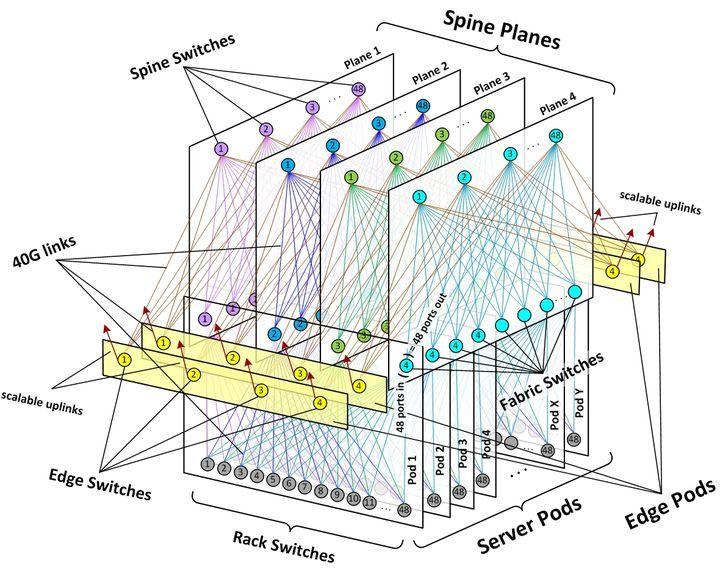

这里可以引申出一些关于数据中心硬件架构的介绍,比如,叶脊架构(Spine-Leaf)。这个最早是由Facebook提出的,其本质就是为了适应目前正在布局和建设的全球超大型数据中心,对比传统的网络架构,数据吞吐量能力更强(笔者注,这点在智能控制类PCBA的EE可靠性测试中也为必要项)。叶脊架构可以划分为机柜层、Leaf 层和 Spine 层,对应的设备分别为,机柜层(服务器、ToR 交换机、光模块);Leaf 层(Leaf 交换机、光模块);Spine 层:(Spine交换机、光模块)。

叶脊架构主要以 Server 到 Server 之间互联流量为主,为了实现内部互联,如机柜间互联以及 Leaf-Spine 互联的短距高速高模块需求大幅增加。而 Server 到 Spine 交换机流量压力得到很大缓解,数据中心设计往往向上也呈现一定的收敛比。与此同时,交换机也伴随升级:端口数量越来越多,芯片转发速率越来越高。国内的阿里腾讯,也采用类似的架构方式。

更具体的,大概就是数据中心的部署,也即是服务器的部署,交换机可以部署在机柜的顶部,中部,或者底部,通常在顶部利于走线,这种应用较多,因此也称之为ToR(Top of Rack)交换机。

Leaf层,更多起到承上启下的作用,主要由Leaf交换机构成。通过ToR 交换机与 Leaf交换机对应划分出的结构也被称为 Server Pods。数据中心在部署时根据需求,划分为 N 个 Server Pods。N 的数量少则几十,多则几百。边缘的 Pod 又被称为 Edge 平面,负责出口流量,实现数据中心之间的互联。

Spine层:Spine 层是整个数据中心拓扑网络的顶层。

总体来讲,数据中心架构主要目标是服务于数据中心运营支持,既有利于增加单个数据中心的服务器容量,也有利于服务器网络的彼此互联。

除了在数据中心架构的搭建,对应的基础支持,也需要有相应的进步,目前最重要的两块,就是散热和供电。

首先来看散热,我们知道,在数据中心机房,为了应对散热的问题,目前总体还是通过风冷解决。首先在配置的服务器和交换机整机模块上,就带有风扇,同时,在机房中还会额外设置空调,以及精密空调去专门调节温度,使得服务器的工作环境保持在合适范围。但是,这同样带来耗电问题,成本压力,甚至整机可靠性问题,同时还带有额外的噪音。那么是否有方案改善相关问题呢。我们不妨思考一下上文提到的海底服务器方案,这种脑洞大开的方式是否有更适合当下基建能力的方案呢。

其实,全球各大企业在液冷领域纷纷展开尝试,比如阿里云2016 年首次推出浸没液冷系统,2018 年 6 月位于河北省张家口市建成了全球互联网行业第一个浸没液冷生产集群,总规模共计约 2 千多台液冷服务器,包括通用计算型、SSD/HDD 存储型液冷服务器。在实际的案例中,或许对比国外互联网公司,阿里已经通过一些实际场景验证过,比如阿里巴巴电商 2018 到 2020 的双十一活动,张家口的数据中心就很好的支持了当时的超大流量。

同时,刨除脑洞大开的海底服务器想法,或许当前的产品趋势方面,浸没液冷服务器或许将成为下一个产品形态趋势。ODCC发表的《浸没液冷服务器可靠性白皮书》中也有专门提到过:通过分析可知,液冷服务器具有较低的失效率,整体液冷服务器对比风冷服务器部件故障率下降约 53%,整体服务器可靠性符合预期。(来源:“开放数据中心委员会”。)

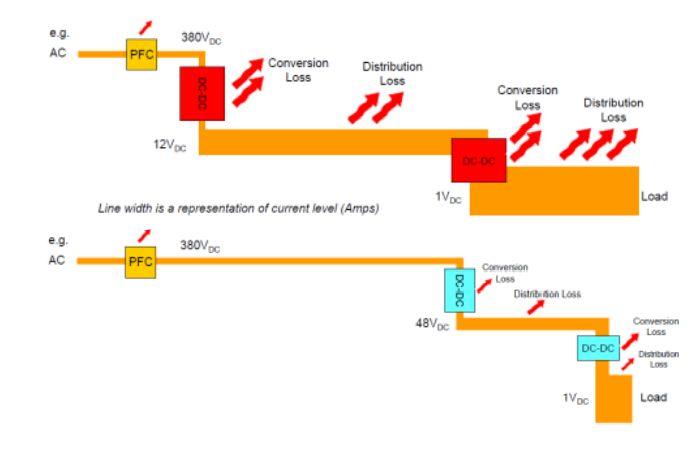

我们在上文中也讨论过过,散热是数据中心面临的一大问题,那么供电中,根据能量守恒,本来就会有部分热能散出,那么至少我们可以思考如何减少这部分热能的损耗。在电力分配中,产生的热能(焦耳)与 电流x电阻,通常指功率损耗,单位为瓦(瓦=焦耳/秒)。For DC, PLOSS = I2 x R – For AC, PAVE = IRMS 2 x R

对于相同的功率(P = V x I),保持电压高(所以电流低),更有机会减少损耗。诚然,这是从整体架构减少能源损失,相应地,也可以减少冷却需要面临的挑战。

所以不只在数据中心应用,在Micro-grids以及Aircraft等领域应用,HVDC也同步发展。更通用的电压级别。

然而,数据中心的快速增长也带来了能源消耗问题。比如,对芯片性能的设计需求,导致散热方面增加。一般CPU(中央处理器)TDP(热设计功率)也逐渐增加,从100W左右增加到400W左右,甚至用于人工智能(AI)训练的图形处理器(GPU) ing的功率最高可达2.6kW,这些,在当前的部分超大型服务器架构中,已经非常普遍,随着处理信息,以及计算量增大,特别是,如果着眼于元宇宙所描述的应用场景,通过VR,AR等终端设备进行社交互联,游戏,办公,会议等丰富场景,在未来,AI训练GPU功率有望达到10kW。毕竟在处理AI深度学习计算时,GPU比CPU更强大,随着计算应用变得更加复杂,GPU将变得更加流行。或者保守一点说,芯片架构可能会做更多层面的整合。

数据中心的内部冷却系统每年消耗大量的电力,大大增加了运行和维护成本,因此,如何提高数据中心的散热效率,提高数据中心的可持续性已成为社会普遍关注的焦点,其中最有效的一种就是液体冷却。首先比热容层面,液体作为传热介质具有天然优势,到热效率更高,也可以避免服务器室内局部热点等问题,对于整体环境空气循环的控制要求降低了。也就是说,既可以更迅速散热,也节省额外的降温设备,比如风扇配件,精密空调等。综上,液冷系统可以显著降低数据中心以上的所有能源消耗和PUE(Power Usage Efficiency电力使用效率)。 此外,由于液冷系统的泵和其他仪器要比风扇安静,液冷系统的噪音要比风冷系统低得多,因此可以创建“安静的数据中心”。

图片来源:Picture from PSMA HVDC

所以首先,为了应对散热问题,从服务器形态来看,整机服务器,交换机等产品形态有所升级改变。那么,除了产品形态本身的调整,还有哪些部分做出了变化了呢,其中一块就是——供电模式。

在供电方面,电力系统网络分为三个部分; 发电、输电和配电。输电系统用于将发电系统与负荷连接起来。采用高压输电,减少输电损耗。分为HVAC和HVDC两种;电源以交流电源的形式产生,大部分负载被设计成运行在交流电源上。因此,在传统的传输系统中,电力是通过HVAC传输线传输的,但也有一些缺点,实际上目前越来越多应用开始像HVDC方向发展。

当然,我们知道很多高功率架构应用会有相似之,实际上电源行业,关于UPS与HVDC何者才是下一趋势方面,是由一定争议的。在具体的应用方面,大家看法会有不同。当然,笔者在很多报道中,都看到大家会把一些概念混淆,或者严格区分UPS和HVDC,导致有些新闻看起来一头雾水,一会儿说HVDC要全面替代UPS啦,一会儿又说HVDC是UPS的关键,究其原因,或许和翻译,以及表述有关。不间断电源系统(uninterruptable power System, UPS)和高压直流(high voltage Direct current, HVDC),前者表述一整个供电系统,后者是一种供电架构。

实际上,我们如果从供电系统角度来解读,UPS不间断电源供电系统是由UPS蓄电池提供不间断电源,经过直流交流直接的变换,主要由UPS主机,蓄电池,电池箱等组成。高压直流HVDC供电系统,是由交流配电单元,整流单元,直流配电单元等组成,主要为通信设备供电。

所以,我们只能理解为,传统UPS的主流方案,是更多一HVAC(High voltage alternating current)方案为主流,但是作为当前的UPS系统,总体方案更加倾向于HVDC高压直流方案了。其实从方案架构上,我们知道,能源方案领域,服务器电源与通信电源在功率级别以及方案架构上有一定相似性,而前两年通讯电源市场发展速度较快,特别是基站建设速度斐然。当然,目前基站设备供电主要采用-48V DC远距方案,而随着5G时代的到来,因为5G的MIMO方式,总体基站数量增加电池的集中部署导致AAU与机房的空间距离进一步增大,有望推动HVDC直流远距方案和DPS分布式供电方案的出现。与传统UPS方案相比,升级到HVDC具有更高的运行效率、更少的占地面积、更低的投资和运行成本, 2018年下半年以来,高压直流产业化、市场化的制约因素逐步消除,市场需求进一步开放,行业进入加速增长期。在高压直流输电系统的配电装置中,如空气开关、继电器等都需要在高压直流下工作,选型要求高,成本高,且高压直流输电存在一定的安全风险。 不间断电源UPS系统的供电效率得到了很大的提高,可靠性和可维护性得到了加强,当前部分品牌整机效率达到95%以上。

综合以上,我们可以看到在数据中心基础设施建设方面,温度控制,与供电方案都非常重要,并且二者在设计中有相互交叉的领域,可以说在整体解决方案中,良好的热能回收,温度控制,结合效率更高的整体供电方案,将是打造大型数据中心建设的关键。也由此,大数据行业的成长,不仅仅在我们理解的“飘在云端“的软件架构,与数据管理层面,更潜移默化带动基础设施建设,能源管理,电路规划等方面的技术成长,并积极带动很多相关企业的发展。

同时,“大数据“发展,也像是通讯基站发展一样,影响到我们更多与新能源相关的产业发展。我们知道数据中心亦或是通讯基站耗电量巨大,所以我们已经基本介绍过,数据中心在总体设计方案上,如果优化软件架构,硬件开源,合理配置供电模式等操作,同时,好消息是,全球太阳能发电量将从2015年的3.91亿瓦增加到2020年的6亿瓦,并且再成本方面也有优势,到2020年,全球太阳能价格将与火电价格持平。基础设施耗电量的增加,传统的备用电力策略也需要进行改革。

此外,我们知道UPS 电源或者直流开关电源连接着电池,用于能量储存,保证系统运行的稳定性。传统的铅酸电池密度低,体积大,重量大。有些地点可能难以容纳铅酸蓄电池的巨大重量和尺寸。锂电池已经发展了大约20年。随着电动汽车特别是近年来的快速应用,锂电池的成本迅速下降。 预计2021年的资本支出(CAPEX)将与铅酸电池持平,锂电池具有周期长、速率高、体积小、重量轻等特点,成为能源领域替代铅酸电池的最佳选择。

综上,我们从“元宇宙”令人困惑的概念生发出来,理解大数据,进一步了解了,大数据发展是从何推动实业发展的。从“硬件开源”的美好愿景,到超级大型数据中心的新型产业模式,以及对应推动其他领域技术的共同进步。比如,大型数据中心,通信设备的建立,同时也推动了光伏与储能等新能源领域产业的发展。综上,从基础设施,硬件发展的角度,我们或许可以对“元宇宙“有更强信心,并抓住机遇,发展与之相关的领域,推动技术变革。

芯耀

芯耀

251

251