大模型热潮持续高涨,应用场景不断拓宽,业界正积极探寻其规模化落地的关键突破口。之前,业界谈论起模型,最多的话题是每Token的性价比,应用场景多集中在对话、客服等领域。

但是,随着大模型的能力逐渐增强,它与外部工具的交互能力增强,视觉理解能力、深度思考等能力都在增强……然而,当模型能力突破临界点,应用场景日益复杂且深入企业核心时,一个根本性的挑战浮出水面: 大模型落地千差万别,什么样的算力才能跟得上快速迭代、严苛多变的需求?

日前,在火山引擎2025 FORCE原动力大会上,英特尔提出,“芯云协同”的技术范式迈入新阶段,已经从技术融合升维到生态共建,通过推动端侧一体机与云端算力的深度联动,企业可以构建本地隐私保障+云端弹性扩展的融合架构。

大模型一体机:破解本地化“隐私、性能” 部署挑战

大模型在企业落地时面临一个核心挑战——企业往往需要鱼与熊掌兼得,既要核心数据绝对掌控,又要实时获取最先进AI能力。本地部署的一体机虽然可以确保数据不出域,但可能难以跟上快速迭代的模型;如果采用云上大模型,隐私数据、保密信息又有泄露的风险。

这就使得高性价比的云边一体机成为企业进行数字化转型的重要基础设施。一方面,云边一体机硬件平台具备足够好的性能和性价比;其次,高性能的开源大模型降低了技术门槛,能够满足更多应用场景。

为满足企业边缘场景的AI部署需求,英特尔推出了基于锐炫GPU的高性价比智算一体机方案。 这款原本主打游戏、内容创作等消费领域的GPU,为何能担此重任?

英特尔技术专家指出,关键在于显存瓶颈的突破。 当前主流开源模型已普遍支持高达几十甚至上百K的上下文窗口,但显存容量却成为制约其能力释放的关键短板:一方面,庞大的模型权重与对话过程中累积的海量KV Cache持续消耗显存;另一方面,企业级应用的上下文需求正从10K激增至32K以上,对显存提出了更严苛的要求。

瞄准这一痛点,英特尔推出了基于锐炫GPU的高性价比多卡方案。锐炫GPU从2023年主打游戏的16GB显存锐炫A770,演进至2024年专为AI优化的24GB显存锐炫Pro B60,显存容量与性能的双重提升,使其成为边缘AI推理的理想算力平台。该方案通过oneCCL通信库实现了高效的多卡并行扩展,并预置EAP容器封装底层AI能力,使企业无需重构现有应用,即可无缝接入千亿参数大模型时代。

如下图所示的一机四卡配置方案,其设计核心在于极致性价比。该技术专家强调,本地部署一体机的总成本(TCO)需综合考量硬件、软件与服务。唯有将硬件成本控制在足够低的水平,才能为ISV(独立软件开发商)和SI(系统集成商)伙伴留出合理的利润空间,共同推动方案落地。

据了解,英特尔与火山引擎的HiAgent、华胜天成联合打造了基于英特尔锐炫的HiAgent一体机方案,可以为用户打造低成本入门的AI应用,提供灵活进阶路径。其中,由火山引擎HiAgent 提供大模型能力中台,全方位支持智能体规划、开发、应用、优化的全生命周期迭代;英特尔锐炫GPU一体机提供超高性价比算力平台和开放的软件生态,可以降低用户大模型算力门槛;华胜天成则提供全面的服务能力与丰富的应用开发经验,保障方案的整体交付和落地。

该一体机方案破解了当前AI落地的核心痛点,即为市场提供高性价比、可扩展性更强的AI一体机方案,企业可以灵活选择私有化的部署路径,实现从低成本到规模化扩展的平滑进阶,让AI真正能够转化为行业的生产力。

释放大模型潜力,CPU异构算力如何扛起大旗?

大模型落地不仅涉及训练推理,还需覆盖数据治理、RAG增强检索(含向量化/重排/搜索)、智能体服务及隐私保护等全流程。此类负载对GPU资源消耗巨大,且高度依赖CPU的深度协同能力。

火山引擎第四代ECS实例家族正是基于这些诉求设计,它搭载了英特尔至强6处理器与自研DPU,在通用计算、高算力及I/O密集型场景都实现了性能突破。例如通过充分利用实例中至强6的AMX矩阵运算加速器,任务耗时最多可减少90%,有效助力了RAG应用全链路提速;Wide&Deep模型经AMX优化后,搜索推荐场景CPU推理吞吐提升114%,能够有效平衡推荐准确性与多样性;此外,基于CPU和GPU的硬件机密计算能力,火山引擎在固件、内核、虚拟化以及操作系统等方面做了深度调优,构建全栈防护。

第四代ECS实例的快速迭代,直接体现了算力在AI技术发展中的核心作用——高性能的异构算力直接关系到大模型的性能和效率,以及迭代创新的速度。

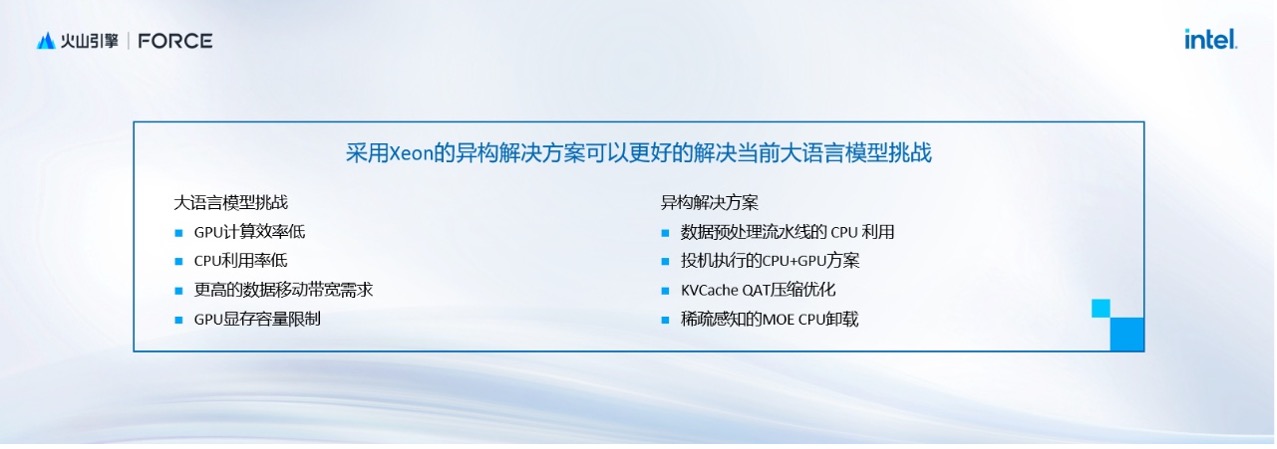

针对大语言模型所面临的算力利用率低、带宽瓶颈、显存限制及KV Cache存储压力四大挑战。英特尔通过异构优化方案可以充分发挥至强CPU特性:例如针对AI服务器中CPU利用率不高的问题(stable diffusion微调任务中,CPU空闲时间甚至占总时间的97%),通过将预计算任务分流至CPU,与GPU并行,整体方案性价比可提升10%。

值得强调的还有投机执行,该技术灵感来自于CPU设计,主要思路是用计算换取时间,以早期的计算过程去预测下一步的执行阶段。至强6性能核处理器在投机执行时可以运行小模型,释放GPU资源,从而降低推理延迟。

此外,KV Cache 作为大语言模型生成文本时的核心组件,其庞大的存储开销构成了另一大挑战。以一个日活用户1万的多轮对话系统为例,单日产生的KV Cache规模可攀升至TB级(4T);若对话日活达到千万级别,其容量更将跃升至PB级。面对如此惊人的数据量, 当需要在不同数据集群和存储介质间迁移流动时,数据迁移效率(特别是对传输带宽和存储I/O的要求)便成为难以逾越的瓶颈。

英特尔技术专家介绍了KV Cache管理方案:针对不同的计算设备,KV Cache会有一个从热到冷的迁移过程。在CPU最终的磁盘落盘阶段,通过英特尔至强QAT加速器,可以实现对压缩优化的硬件加速,能够显著降低多轮对话首词延迟。

还有针对DeepSeek稀疏感知的MoE CPU卸载解决方案,通过模型分析器和调度器,可以调度MoE不同专家在GPU和CPU上的运行,最大限度降低显存限制门槛。以8卡GPU服务器运行DeepSeek-R1模型推理为例,可以实现DeepSeek整体并发量2.45倍的提升。

芯云协同:构筑普惠算力的关键路径

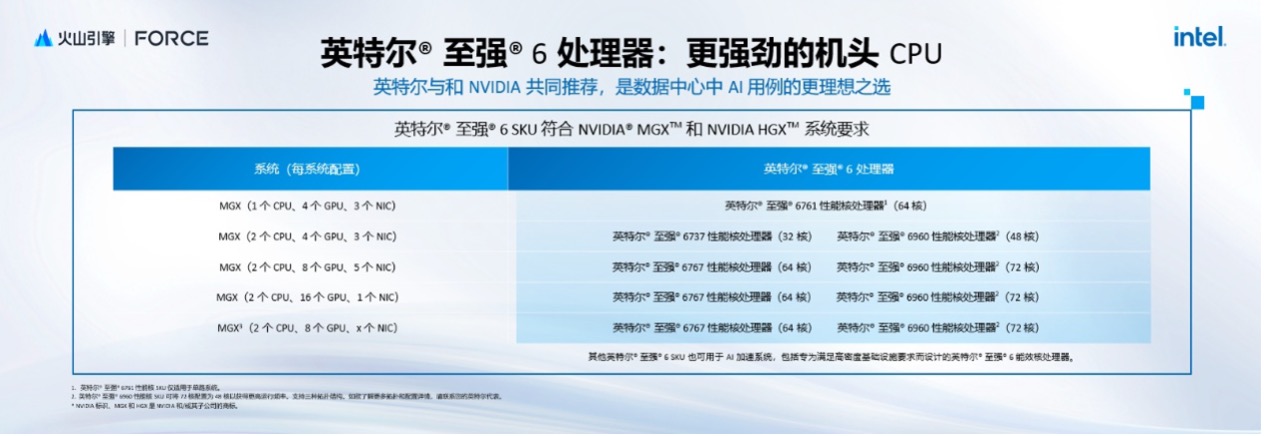

解决了本地化部署、边缘推理效率,要在云端支撑大模型训练、推理以及更复杂的AI全流程,需要数据中心CPU实现前所未有的突破。

2024年发布的英特尔至强6处理器,正是通过模块化解耦架构,将I/O控制单元与计算核心分离设计,显著简化了能效核与性能核的资源管理并降低生态验证复杂度。其计算核心支持灵活的核数配置,再结合全栈优化的BIOS框架,为多元化负载提供了高度弹性的算力基础。

在性能层面,至强6展现出了多项行业标杆水准:至强6能效核最高配备288物理核,可满足高密度计算需求;至强6性能核在行业中首次支持MRDIMM 8800MT/s内存,使总内存带宽较上代提升2.3倍;搭载CXL 2.0协议,为未来内存容量与带宽扩展铺平道路。

同时,专用加速引擎也成为其关键突破:4个独立QAT单元可高效卸载24-32个CPU核的压缩负载,释放宝贵算力;AMX指令集直击AI计算瓶颈,大幅提升处理效率。该设计使至强6能够高效支撑从数据压缩到复杂AI推理的多样化场景。

基于这些特性,在通用计算、Web service及AI等领域,至强6900系列CPU总体提升了2倍以上的性能,同时提高了1.4倍的性能功耗比改善。在同样功耗的情况下,至强6处理器相对上一代提升了1.4倍以上的性能。对于云服务商而言,其价值尤为凸显——可以实现2倍的核心密度、20%的单核性能提升、60%的性能功耗比优化,最终达成30%的TCO代际收益,为AI规模化落地提供关键支撑。

英特尔技术专家指出,企业有大量的私有化数据需要被利用起来,而RAG是非常适合的切入方式。其核心是从向量数据库检索关联信息,利用大语言模型信息综合能力,来提升大语言模型的输出质量。

RAG的许多环节都可以用至强6处理器来提升性能,比如在NGINX前端,至强6的QAT加速器可以加速安全通道建立的过程;在数据预处理阶段,依托oneDNN/OpenVINO软件,调用AMX指令和大容量LLC Cache,可以加速OCR/CLIP模型推理速度;进行信息向量化时,结合英特尔IPEX优化的PyTorch及NIC量化工具,可显著提升Embeddings与Rerank环节的性能,同时基本不损失精度;此外,QAT/IAA/DSA专用加速单元可以卸载压缩/数据搬移任务,释放CPU资源。

写在最后

大模型产业落地仍面临深层矛盾,既有云上模型快速迭代优势与本地数据安全的冲突,也有部署成本和效能瓶颈的挑战,还有复杂场景对敏捷部署的需求……这些看似矛盾的需求面前,是对底层算力的重构呼唤——它需要突破硬件边界实现隐私与性能的共生,需要灵活配置资源实现效能提升,更需要将异构算力转化为迅速响应的基础能力。

英特尔与火山引擎的合作正为此铺平道路,不论是高性能的至强6处理器,还是微服务化容器集成,或是端到端的链路优化及前瞻性的Agent架构,都在着力满足从本地灵活部署到云端弹性的全场景需求,最终便于企业在云边一体的算力基座中寻得最优解。

来源: 与非网,作者: 张慧娟,原文链接: https://www.eefocus.com/article/1860310.html

芯耀

芯耀

1555

1555