做边缘端 AI 手势识别,选对硬件和开源工具是效率关键!最近在恩智浦 i.MX RT700 MCU 上落地手势识别项目,从硬件适配到模型部署踩过不少坑,最终靠 Google MediaPipe 开源框架 + RT700 自带的 NPU 加速,实现了高效开发。今天把完整实战思路拆解开,从 MCU 硬件优势、AI 开发四步走,到模型串联逻辑,帮你少走弯路,快速落地边缘端 AI 应用。

1. i.MX RT700:为边缘AI而生的MCU

i.MX RT700集成了5个计算内核,包括:

- 主Cortex-M33核(325MHz)

- 高性能HiFi 4 DSP(负责复杂DSP/音频处理)

- 超低功耗感知子系统(次级Cortex-M33+HiFi 1 DSP)

- eIQ Neutron NPU——最关键的是,这款NPU可将AI处理速度提升172倍!

这种架构消除了对外部传感器集线器的需求,显著降低了系统复杂性和BOM成本。特别适合可穿戴设备、智能家居等边缘AI场景。

2. MediaPipe:Google开源的AI解决方案

在技术选型时,我们选择了Google MediaPipe(https://ai.google.dev/edge/mediapipe/solutions/guide?hl=zh-cn)这一跨平台机器学习框架。它特别适合实时多媒体应用,并提供丰富的前置模型,包括我们需要的手势识别解决方案。

MediaPipe的核心优势:

3.拆解 MediaPipe 4 个模型,搞懂 “串联逻辑”

拿到 MediaPipe 的模型后,最头疼的是 “不知道怎么用”—— 毕竟是开源框架的模型,没详细文档说明流程。后来通过分析每个模型的输入输出,终于理清了 4 个模型的 “串行关系”:一环套一环,每个模型的输出都是下一个的输入,最终实现手势分类。

先说明:MediaPipe 的手势识别模型包是.task格式,直接解压就能得到 4 个核心模型 ——hand_detector.tflite、hand_landmarker.tflite、gesture_embedder.tflite、canned_gesture_classifier.tflite,下面逐个拆:

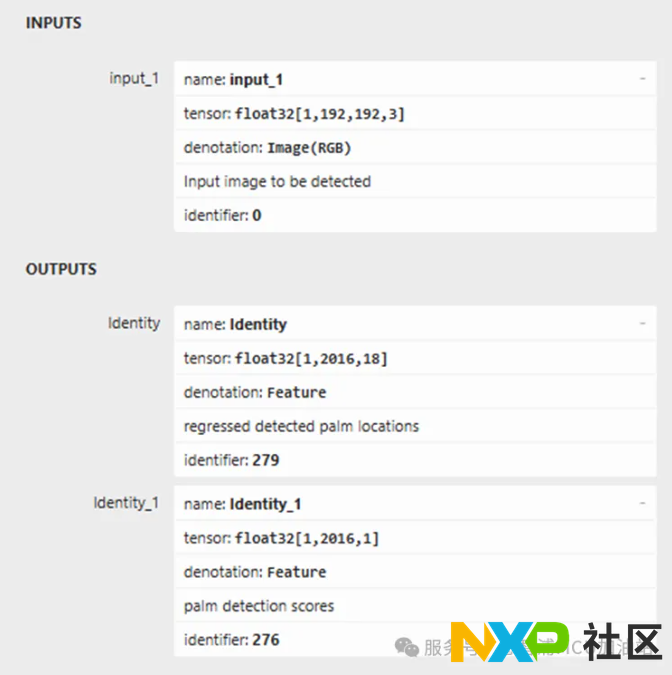

3.1 第一步:hand_detector.tflite—— 先 “找到手”

- 作用:检测图像中是否有手,以及手的具体位置(坐标)和置信度得分。

- 输入:常规 RGB 图像(适配 RT700 摄像头采集的图像格式)。

- 输出:手部位置框(x/y 坐标)、手部存在置信度 —— 这一步是基础,只有先定位到手,后续模型才有处理对象。

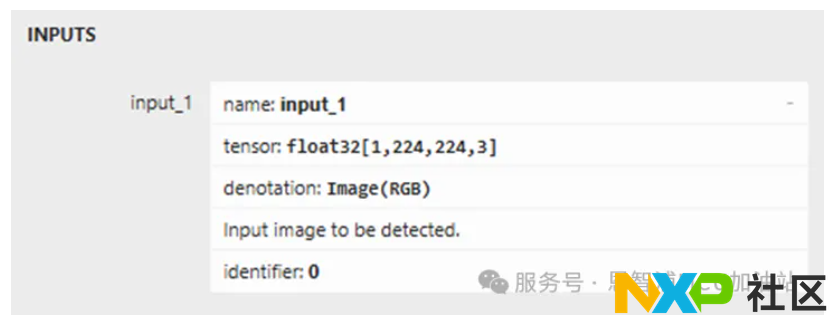

3.2 第二步:hand_landmarker.tflite—— 再 “描关键点”

- 作用:基于第一步的手部位置,识别手部关键点(比如手指关节、掌心),还能区分左右手、判断是否有手。

- 输入:224×224 大小的 RGB 图像(需根据第一步的位置框裁剪、缩放,适配 RT700 的图像预处理能力)。

- 输出:

- 左右手标记(left/right);

- 手部存在状态(有 / 无);

- 手部关键点坐标(两种:归一化坐标 + 世界坐标,实际测试后发现 “归一化坐标” 更适配 RT700 的 NPU 计算)。

- 关键:这一步的输出,会直接传给下一个模型,是 “手势特征提取” 的核心数据。

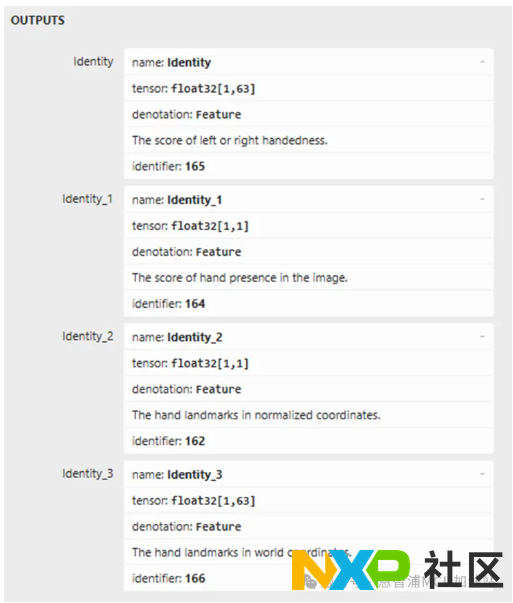

3.3 第三步:gesture_embedder.tflite—— 提取 “手势特征”

- 作用:把第二步的关键点数据,转化为 AI 能识别的 “特征向量”。

- 输入:3 个数据(刚好对应 hand_landmarker 的输出):

- hand(手部关键点信息);

- handedness(左右手标记);

- world_hand(世界坐标关键点)。

- 输出:128 维特征向量 —— 这一步是 “承上启下”,把具象的关键点,变成抽象的特征,方便后续分类。

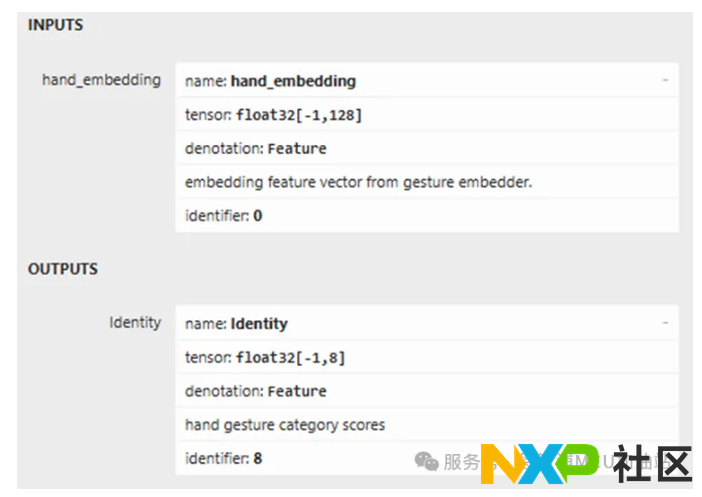

3.4 第四步:canned_gesture_classifier.tflite—— 最终 “分出手势”

- 作用:根据 128 维特征向量,判断具体是哪类手势。

- 输入:gesture_embedder 输出的 128 维向量(直接适配 RT700 的 NPU 推理输入格式)。

- 输出:8 类手势的得分(置信度),对应具体手势:

0 - 未知手势(Unknown)、1 - 握拳(Closed_Fist)、2 - 开掌(Open_Palm)、3 - 指上(Pointing_Up)、4 - 拇指下(Thumb_Down)、5 - 拇指上(Thumb_Up)、6 - 胜利(Victory)、7 - 爱心(ILoveYou)。

这套方案的核心优势,就是 “软硬结合”:

- 硬件上:靠 RT700 的 5 核算力 + NPU 加速,解决边缘端 AI 的 “实时性” 和 “低功耗” 问题,7.5MB SRAM 保障模型和数据的快速存取;

- 软件上:借 MediaPipe 的开源模型和模块化管道,跳过 “数据集标注”“模型从零训练” 的坑,重点攻克 “模型串联” 和 “NPU 适配” 这两个核心难点。

4. 部署挑战与NPU加速策略

虽然有了现成模型,但嵌入式部署才是真正挑战。i.MX RT700的eIQ Neutron NPU在这里发挥了关键作用:

优化重点:

- 模型预处理流水线重构

- 内存占用优化(充分利用7.5MB SRAM)

- NPU专用指令集调优

性能收益:

- 相比纯CPU推理,NPU加速带来172倍性能提升

- 实时处理能力满足30fps+的手势识别需求

- 功耗控制完美适合电池供电设备

5. 实战价值与应用前景

这种"强大MCU+成熟AI框架"的组合,为嵌入式AI开发提供了新范式:

- 降低开发门槛:无需从零开始训练模型

- 加速产品上市:利用经过验证的解决方案

- 发挥硬件潜力:充分释放专用NPU的性能优势

最后给个小建议:落地时先从 “单模型调试” 开始 —— 先确保 hand_detector 能正确定位手,再逐步调试后续模型,遇到预处理问题时,可参考 RT700 的 eIQ SDK(恩智浦官方提供),里面有适配 NPU 的图像预处理工具,能少踩很多坑。

站在 MediaPipe 这个 “巨人” 的肩膀上,再结合 RT700 的硬件优势,边缘端 AI 手势识别其实没那么难 —— 关键是找对资源、拆懂流程,把开源工具和硬件算力真正结合起来。

芯耀

芯耀

2622

2622