随着边缘AI应用进入爆发期,从智能终端到车载系统,对边缘侧算力提出了前所未有的需求。系统性能、效率与灵活性等多重挑战,加剧了边缘处理器的竞争。

Imagination最新推出的E系列GPU,针对边缘图形处理与AI加速计算应用,在给市场带来新选择的同时,也给这一领域已有的处理器带来潜在挑战,首当其冲受到威胁的可能就是NPU。

E系列GPU具备两项核心创新:

Neural Cores(神经核):最高可扩展至 200 TOPS(INT8/FP8),显著提升 AI 与计算性能;Burst Processors(爆发式处理器):创新架构设计,使边缘应用中平均功耗效率提升35%。

针对AI工作负载,E系列GPU的INT8/FP8 算力可在2到200TOPS 之间扩展,涵盖图形渲染、桌面和智能手机等领域,可实现自然语言处理、工业计算机视觉以及自动驾驶等应用。首款 E系列 GPU IP将于2025年秋季正式上市,目前已完成授权。汽车、消费电子、桌面及移动版本亦在同步开发中。

GPU+AI深度融合,打破传统方案局限

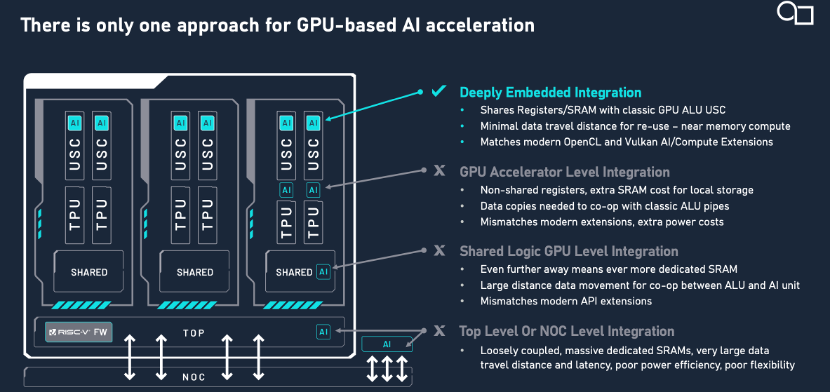

目前,需同时处理图形渲染与AI计算的场景中,常见的解决方案通常采用GPU与AI算力分离的设计架构,即独立部署GPU和专用AI加速模块。这种模式存在明显的局限性:一方面,GPU和AI模块各自需要配备独立的内存(RAM),导致硬件资源冗余;另一方面,两者间的数据交互需通过外部通道完成,不仅增加传输延迟,还会因协同效率低下造成整体能效利用率降低。此外,这种分离式设计限制了算力调度的灵活性——GPU无法与AI模块实现深度协作,任务只能在固定硬件单元中执行,难以适应动态负载需求。

在这种局面下,一些改进方案尝试将部分AI算力嵌入GPU渲染单元。这样虽然减少了硬件解耦带来的问题,但仍需为AI计算分配专用内存资源。同时,AI运算结果仍需与GPU内部渲染管线进行二次交互,这种混合架构增加了数据处理路径的复杂度,难以充分发挥异构计算的协同潜力。

据Imagination中国区技术总监艾克介绍,E系列GPU的核心创新就在于通过深度融合集成架构,解决了上述问题。通过将AI算力与GPU核心渲染管线(如主管线Primary Pipeline与二级管线Secondary Pipeline)深度融合,实现了硬件层面的统一调度与资源共享。

这样带来的好处包括:首先,AI计算单元可以和GPU共享寄存器和内存系统;其次,由于AI计算单元直接嵌入GPU流水线,中间数据无需跨模块传输,实现了数据交互的优化;第三,这一架构设计符合OpenCL、Vulkan等通用计算框架的扩展规范,也和NVIDIA CUDA理念高度相似。

这一架构突破不仅解决了传统GPU与AI加速器解耦设计的效率瓶颈,更通过硬件级融合,为异构计算提供了高密度、低延时的协同计算范式。

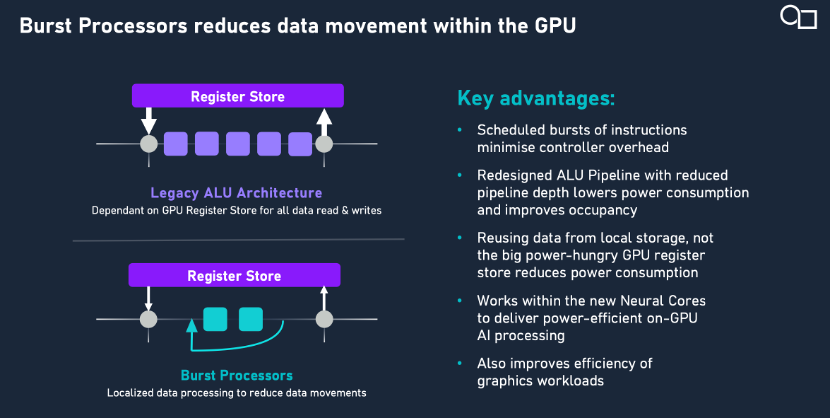

引入爆发式计算,平均功耗效率提升35%

E系列引入全新爆发式处理器技术,该技术通过缩短流水线深度、减少数据在GPU内部的移动,实现了能效提升。在 AI 推理、游戏和用户界面等工作负载下平均功耗效率再提升 35%。

据Imagination方面介绍,爆发式计算是E系列GPU中固有的,它深度集成于硬件底层,重构了GPU的指令调度方式。通过动态识别连续可归类的背靠背(back to back)指令,它可以合并批量任务,对尽可能多的数据进行复用和共享,提高了数据利用率,减少指令解码器的开销。

更重要的是这种新的调度方法,不管是进行图像处理,还是进行通用计算,还是人工智能计算,都可以有效利用爆发处理器的能力。

可编程架构持续满足AI演进需求,NPU受挑战

GPU作为可编程处理器,能够持续应对AI、计算和图形工作负载的演进需求。且E系列神经核,通过在GPU内部深度集成了AI加速能力,能够与更广泛的GPU及异构计算软件生态实现无缝协同,其算力可通过OpenCL 等主流 API直接调用,开发者借助oneAPI、Apache TVM 或 LiteRT等开放标准工具,能将工作负载迁移至神经核。Imagination的计算库与高度优化的图形编译器,进一步释放了GPU的全部潜能。

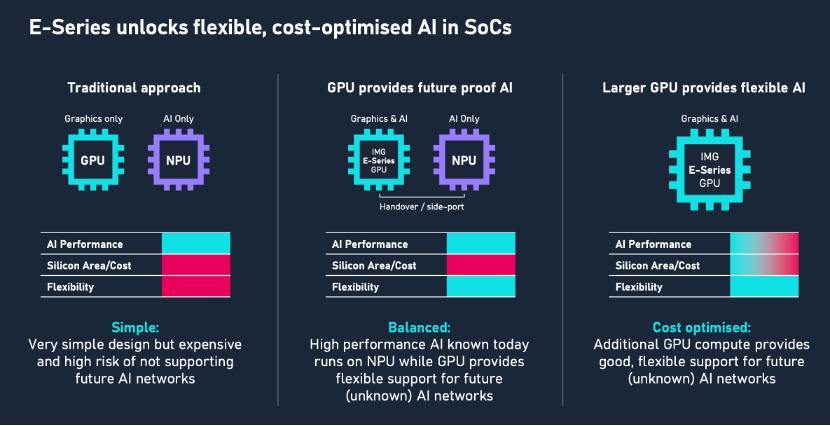

Imagination方面指出,对于传统的图形与NPU分开的处理方式,或是SoC的配合方式,由于缺乏灵活性,且面积大、成本高,可能会面临淘汰。

推测Imagination所指,主要是强调了E系列GPU IP重构了图形与AI计算的协同方式,进而对传统方案形成了替代优势。

可以从两方面来看待,一部分是因为传统分立式架构的固有短板,由于独立部署GPU与NPU需分配两套计算单元及配套内存,导致芯片面积、成本攀升;且跨模块数据交互依赖外部总线,时延高、带宽受限,难以应对实时性要求高的混合负载场景。

另一方面则从E系列GPU的核心创新来看,这是一种原生的异构融合架构,通过将AI计算与图形管线深度集成,在灵活性、效率方面都有优化。并且,当应用场景需要更高的AI算力时,可通过专用接口与外部NPU联动,实现算力扩展。

Imagination方面指出,NPU是为了特定目标而设计,比如5~7年前,NPU是为了去解决卷积神经网络(CNN)问题,但现在Transformer大模型应用越来越普遍,那么如果五年之后,又会出现什么类型的模型?这是无法预测的,也是NPU面临的一大挑战。相对而言,GPU 具有很高的可编程性,可以应对未来新的AI模型。

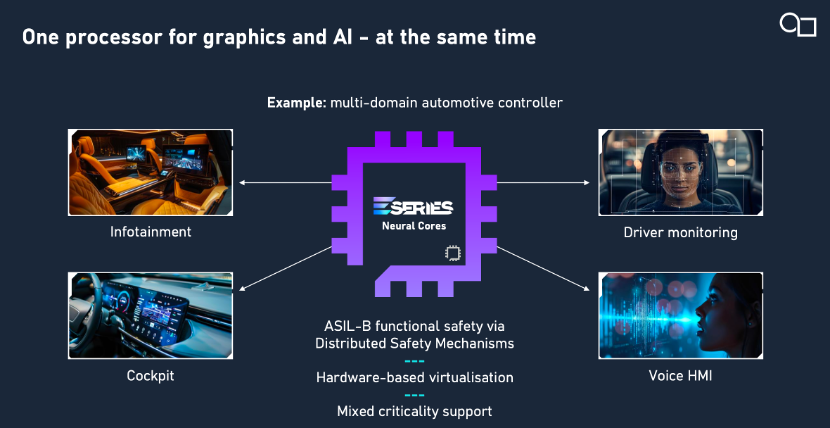

一款 GPU,满足更多任务

当代设备日益复杂,处理器需同时支持图形与AI多项工作负载。为保障用户体验,实现高质量服务(QoS)和清晰划分任务优先级至关重要。E系列在前代产品的多任务处理能力基础上实现了增强,将Imagination GPU支持的、具备硬件加速且零开销的虚拟机数量从8个翻倍至16个,并提供了先进的QoS支持。E系列GPU的多核版本可以利用额外的核心来提升性能或增强灵活性。

对需要同时运行图形与计算任务的系统来说,E系列GPU能够同时处理多种图形工作负载、多种AI工作负载,或图形与AI工作负载的组合。它提供了一种高度灵活的解决方案,既无需依赖额外的向量处理器或固定功能 AI 加速器,又能在降低整体系统设计成本的同时,实现面向未来的可扩展性。

Imagination这种通过同一IP覆盖多样差异化需求的方案,既具备较强的场景泛化能力,同时有助于客户缩短产品研发周期,这是其独到的竞争力,也有助于开发者在多种应用场景和设备上部署AI应用。

根据Imagination方面的介绍,以下是其E系列GPU几个典型的落地场景:

图形与AI联动的创意增强场景:基于GPU渲染后的图像,通过内置AI算力实现超分辨率重建、光影智能优化等,提升视觉效果。或是用户完成基础构图后,AI可即时生成风格化特效或智能补全细节,实现实时交互设计。

智能汽车是一大典型场景。比如车载娱乐系统中,可以用于后座多屏渲染场景,同时通过AI计算实现驾驶员状态监测、座舱语音交互等功能安全相关计算。

此外还有AR/VR设备、移动终端等消费电子场景中,2-200 TOPS的可配置算力,可以用于平衡AI推理速度与能耗效率,满足实时手势识别、图像语义分割等需求。

同时处理图形+AI,未来哪些潜在挑战?

随着设备端推理需求的持续增长,当设备端GPU同时处理AI推理和图形渲染时,会面临哪些硬件资源冲突?Imagination在创新架构中又将如何实现动态资源分配?

对此,Imagination方面表示,目前已经在汽车等复杂设备中看到了这类冲突——单个GPU需要驱动多个显示器(如仪表盘、车载信息娱乐系统、导航或后排娱乐显示屏)。随着系统越来越多地将GPU用作AI等工作负载的并行计算平台中,这个问题变得越来越重要。

例如,在执行AI工作负载时,确保用户界面保持高响应性至关重要。Imagination为多个GPU线程开发了一套丰富的QoS和优先级功能,同样适用于AI工作负载,使系统设计能够精细调整工作负载优先级,并通过线程抢占、线程上下文切换超时和多层优先级等硬件原生支持的功能确保优先级得到维护。除此之外,当需要更稳健的工作负载隔离时,GPU支持基于硬件的虚拟化,可将GPU划分为多个虚拟环境,确保分区之间无干扰。

此外,在支持PyTorch Mobile和LiteRT等API时,算子的碎片化问题不可避免。对此,Imagination如何应对?

据Imagination方面答复,其重点是确保AI算子与GPU支持的功能实现最优映射,这也再次体现出了与NPU相比的关键优势:由于Imagination的GPU是高性能通用并行处理器,未来支持新AI算子只需更新驱动即可。此外,由于市场对其GPU用作通用处理器的编程模型已非常熟悉,无论是由Imagination通过简单的驱动更新实现新算子,还是由用户使用标准通用GPU(GPGPU)编程模型实现,都非常便捷。他强调,支持未来算子的灵活性一直是行业面临的一大难题,而基于E系列GPU的AI方案正是为解决这一问题而设计的。

来源: 与非网,作者: 张慧娟,原文链接: https://www.eefocus.com/article/1836783.html

芯耀

芯耀

1853

1853